Europski pravni stručnjaci sve ozbiljnije rade na regulaciji automatizacije i robotizacije, pa u aktualnom nacrtima zakona, među ostalim, traže da se svim robotima ugrade sigurnosni prekidači za hitno gašenje, ukoliko mašina "poludi" pa krene raditi štetu ili dovede u pitanje sigurnost na radu.

>>>Amazon ubrzava automatizaciju, zapošljava 45 tisuća robota i 230 tisuća ljudi

Osim "crvenog gumba", kreatori europske ekstenzivne pravne materije također najavljuju da će uskoro biti izrađen i zakonodavni okvir koji će omogućiti - oporezivanje robota. Prijedlog izrade legislative za robote prošlog je četvrtka prihvatio Komitet za pravna pitanja Europskog parlamenta.

- Veliki dio naših života sve je više pod utjecajem robota. Kako bismo osigurali da roboti budu u službi ljudi, potrebno je kreirati robustan zakonski okvir - rekla je europarlamentarka koja je predložila i izradila nacrt zakona, Mady Delvaux.

Svi roboti moraju imati sigurnosni prekidač za gašenje

Nacrt sadrži i zahtjev za izradu standarda koji bi inženjerima koji ih konstruiraju naložio da stvaraju sigurne robote koji funkcioniraju u skladu s određenim etičkim pravilima. Kao primjer, navodi CNN, traži se obavezno ugrađivanje sigurnosnog prekidača za gašenje, u hitnim i nepredvidivim situacijama. Također, traži se da se svaki robot može ponovno reprogramirati, u slučaju da dođe do kvara softvera.

"Zakon o robotici"

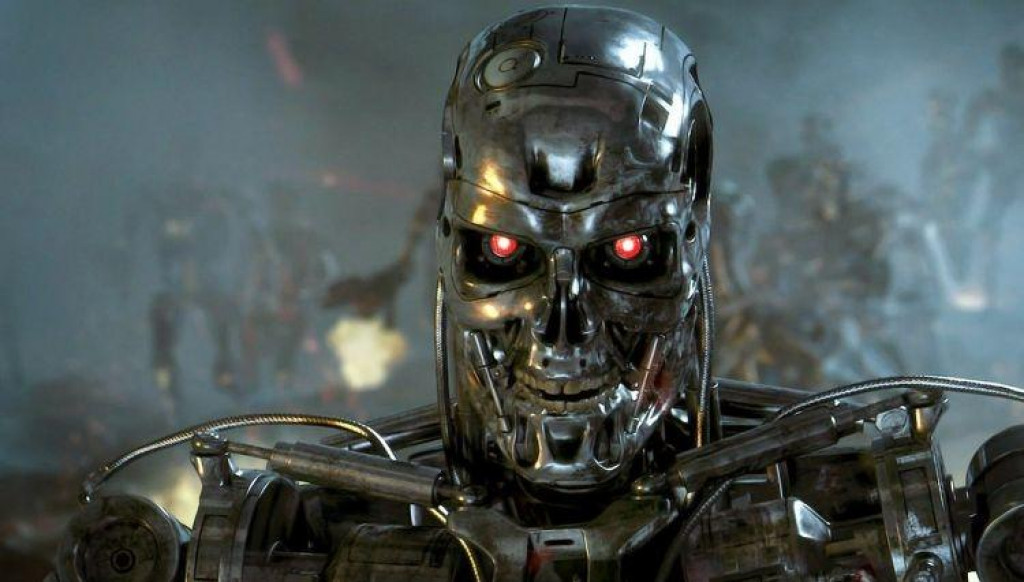

Što je jučer bila znanstvena fantastika, danas postaje stvarnost. Vođeni "Zakonom o robotici" koji je prvi napisao autor znanstveno fantastičnih romana, Isaac Asimov, niti jedan robot nikada ne bi smio nauditi čovjeku.

Asimov je, gotovo proročki, kao jedan od glavnih zakona robotike, naveo da niti jedan robot nikada ne smije nauditi, povrijediti ili ubiti čovjeka. Robotima je dozvoljeno štititi vlastitu opstojnost, međutim, pri tomu nikada ne smiju nanijeti štetu čovjeku.

Roboti su samo roboti, nema emotivne povezanosti

Tvorac filma A.I. (Artificial Intelligence), Steven Spielberg, sigurno se ne bi složio s pretpostavkom također ugrađenom u prijedlog europskih zakonodavaca, da roboti nemaju emocije te je stoga, neprimjereno gajiti iste prema njima.

https://www.youtube.com/watch?v=_19pRsZRiz4

A.I. je, zasigurno, jedan od najvećih filmova ikada snimljenih na temu robotike, a njegova radnja gledatelja vodi u daleku budućnost, na sam rub promišljanja o napretku društva i tehnologije kroz priču o dječaku robotu, Davidu, koji je razvio emocije. Međutim, u stvarnosti, daleko od teoretskog (i hollywoodskog) promišljanja o fenomenu umjetne inteligencije, EU birokrati kažu:

- Ljudima valja jasno poručiti da roboti nisu ljudi niti će to ikada biti. Nikada ne smijete pomisliti kako je robot poput čovjeka i da vas voli - kaže Delvaux.

Tko je odgovoran za "neposlušne" robote?

Prijedlog nacrta zakona sadržava i model osiguranja robota, koji je vrlo sličan osiguranju za automobil. Tim se modelom vlasnika i proizvođača obvezuje na preuzimanje odgovornosti za eventualnu materijalnu ili neku drugu štetu koju počine roboti.

>>>Milijarder Dalio razvija AI koji će preuzeti upravljanje najvećim hedge fondom svijeta

Kako ih se namjerava napraviti poreznim obveznicima, tako se i razmatra pitanje treba li robotima dati ograničena "ljudska" prava. Prijedlog razmatra dodjeljivanje statusa "elektroničke osobe" robotima umjetne inteligencije. Taj status bio bi dodijeljen robotima koji su autonomni, te u odnosima sa ljudima imaju ograničenu autonomiju odlučivanja. Uz prava, dolaze i odgovornosti, pa bi se prema navedenoj logici robote smatralo odgovornima za štetu koju bi počinili.

Trebaju li roboti plaćati porez?

U prijedlogu nacrta Zakona o robotici, eurozastupnica Mady Delvaux predlaže da Europska komisija prisili vlasnike robota da plaćaju porez ili doprinose socijalnim davanjima, ukoliko roboti u velikom broju zamjene ljude na radnim mjestima. U tom kontekstu, vodećim tijelima Europske unije, sugerira da ozbiljno razmotre uvođenje bezuvjetnog osobnog dohotka.